In Steven Spielbergs „Minority Report“ von 2002 jagt John Anderton, ein gebrochener Polizist, Verbrecher, bevor sie zuschlagen können. Washington, D.C., 2054: Das System Precrime nutzt drei Hellseher, Agatha, Dashiell und Arthur, um Morde vorherzusehen. Namen von Tätern und Opfern erscheinen auf Holzkugeln, begleitet von Zeitpunkt und Bildern der geplanten Tat. Ohne Prozess landen Verdächtige in „Verwahrung“. Sechs Jahre lang funktioniert es: Kein Mord in der Stadt. Doch als Anderton selbst als zukünftiger Täter identifiziert wird, bricht das System zusammen.

»Minority Report – Trailer / Thomas Roth You Tube«

Er flieht, lässt sich illegal neue Augen einsetzen, um der allgegenwärtigen Iris-Erkennung zu entgehen, und entdeckt die Schwächen des Systems. Ein dystopischer Albtraum, der in der Fiktion bleibt? Weit gefehlt.

London 2025: Big Data als neuer Hellseher

Was gestern noch als dystopische Fiktion aus Hollywood galt, ist heute gelebte Wirklichkeit. Großbritannien testet ein KI-gestütztes Prognosesystem, das Menschen als potenzielle Gewalttäter identifizieren soll, bevor sie handeln. »The Guardian berichtet«, dass das Projekt von der zivilgesellschaftlichen »Organisation Statewatch« aufgedeckt wurde. Zentrale Inhalte gelangten durch Anträge auf Informationsfreiheit an die Öffentlichkeit. Das Justizministerium in London spricht von „Risikobewertung“.

„Das Vorhaben wird die Merkmale von Straftätern überprüfen, die das Risiko einer Tötung erhöhen, und alternative sowie innovative datenwissenschaftliche Techniken zur Risikobewertung von Tötungsdelikten untersuchen.“ Es soll „Beweise zur Verbesserung der Risikobewertung bei schweren Straftaten liefern und letztlich dazu beitragen […] die Öffentlichkeit durch bessere Analysen zu schützen.“

»Justizministerium London / The Guardian«

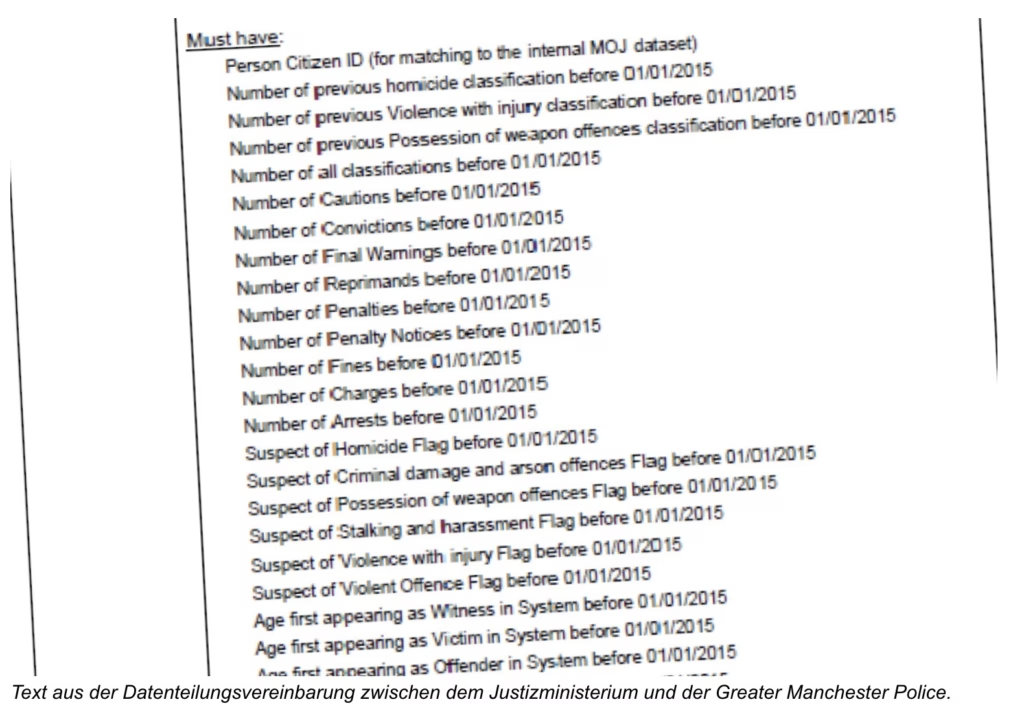

Das Ziel sei es schwere Straftaten zu verhindern. Die Methode: Algorithmen analysieren Daten aus polizeilichen Vorgängen, psychischen Diagnosen, Sozialdaten und maschinellem Lernen. Namen, Geburtsdaten, Geschlecht, ethnische Zugehörigkeit, Vorstrafen, Kontakte zur Polizei, Informationen zu häuslicher Gewalt, psychische Erkrankungen, Sucht, Selbstverletzung, all das fließt in die Bewertung ein.

Das Projekt, ursprünglich „Mordvorhersageprojekt“ genannt, trägt nun den harmloseren Titel „Datenaustausch zur Verbesserung der Risikobewertung“. Doch die Fakten bleiben: Hunderttausende Briten, laut der Bürgerrechtsorganisation Statewatch zwischen 100.000 und 500.000, liefern unwissentlich Daten. Darunter nicht nur Verurteilte, sondern auch Opfer, Zeugen und psychisch Kranke. Das Ministerium bestreitet dies und behauptet, nur Daten von Verurteilten zu nutzen. Doch die Datenaustauschvereinbarungen, die Statewatch durch Informationsfreiheitsanfragen aufdeckte, erzählen eine andere Geschichte.

„Die Datenteilungsvereinbarung zwischen dem MoJ und GMP für das Mordvorhersageprojekt stellt fest, dass Daten zwischen 100.000 und 500.000 Menschen von der Kraft geteilt wurden, um das Tool zu entwickeln.“

»Statewatch«

Die Unschuldsvermutung stirbt leise

Das britische Projekt kehrt ein Grundprinzip der Rechtsstaatlichkeit um: Die Unschuldsvermutung. Wer als „risikobehaftet“ eingestuft wird, landet unter Beobachtung oder in „Betreuung“. Das klingt nach Hilfe, ist aber Kontrolle auf Verdacht.

Was aber passiert, wenn der Algorithmus falsch liegt? Wenn Daten fehlerhaft, voreingenommen oder lückenhaft sind? Algorithmen sind keine neutralen Orakel. Sie verstärken bestehende Vorurteile. Sofia Lyall von Statewatch nennt das Projekt „dystopisch“. Sie kritisiert, dass es strukturelle Diskriminierung im Strafrechtssystem zementiert, insbesondere gegen Minderheiten und einkommensschwache Gemeinschaften.

„Der Versuch des Justizministeriums, dieses Mordvorhersagesystem zu bauen, ist das neueste abschreckende und dystopische Beispiel für die Absicht der Regierung, sogenannte Kriminalitätssysteme zu entwickeln.“

»Sofia Lyall / Statewatch / The Guardian«

Die Forschung zeigt: Solche Systeme sind inhärent fehleranfällig. Dennoch rechtfertigt das Justizministerium das Vorhaben als „Forschungszweck“ zum Schutz der Öffentlichkeit. Ein Bericht soll später veröffentlicht werden. Doch wer kontrolliert die Kontrolleure? Wer prüft, ob die Algorithmen fair sind? Und wie lange dauert es, bis „Betreuung“ in Repression umschlägt?

„Dieses Projekt wird nur zu Forschungszwecken durchgeführt. Es wurde mit vorhandenen Daten des HM-Gefängnis- und Bewährungsdienstes und der Polizei für verurteilte Straftäter entwickelt, um uns zu helfen, das Risiko von Menschen auf Bewährung besser zu verstehen, dass Menschen auf Bewährung weiterhin schwere Gewalt begehen. Ein Bericht wird zu gegebener Zeit veröffentlicht.“

»Sprecher Justizministerium London / The Guardian«

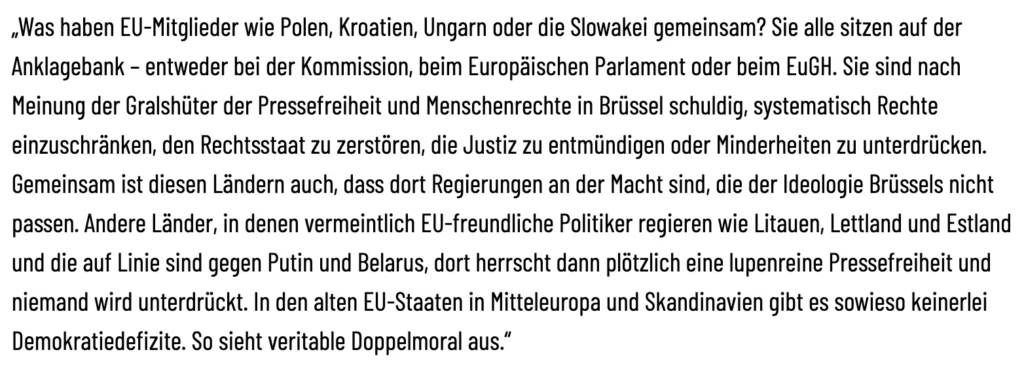

Der Doppelmoral-Test

Stellen Sie sich vor, dieses Projekt würde in Ungarn oder in der Slowakei laufen. Deutsche Medien würden von „autoritärem Missbrauch“ sprechen. Brüssel würde Sanktionen fordern. Doch in einer westlichen Demokratie wie Großbritannien? Da ist es plötzlich “innovative Forschung“ und „zum Wohle der Bürger“. Die Doppelmoral ist offensichtlich.

Überwachung ist also nur dann ein Problem, wenn sie von den „Falschen“ kommt.

Wenn progressive Technokraten sie implementieren, wird sie zur Zukunftsvision. Doch die Wahrheit bleibt: Ein System, das Bürger aufgrund von Wahrscheinlichkeiten sanktioniert, traut ihnen nicht. Es ersetzt das Menschenbild der selbstbestimmten Person durch den „Verdachtsbürger“, immer potenziell gefährlich, immer messbar. Das Projekt, initiiert unter Ex-Premier Rishi Sunak, nutzt Daten von Behörden wie der Greater Manchester Police und der Londoner Polizei.

With £100 million for our AI Taskforce, we are dedicating more funding to AI safety than any other country in the world.

— Rishi Sunak (@RishiSunak) June 12, 2023

We’ll also work with @DeepMind, @OpenAI and @Anthropic who will give us early or priority access to models for research and safety purposes. pic.twitter.com/SKypEisfXX

London ist jedoch kein Einzelfall. In Berlin bastelt das Innenministerium an ähnlichen Systemen. China zeigt, wohin die Reise gehen kann: ein Überwachungsstaat, in dem Algorithmen über Freiheit entscheiden.

Die Lehren aus „Minority Report“

Zurück zu John Anderton. Sein Fall zeigt, wie fragil prädiktive Systeme sind. Er wird als Mörder markiert, weil die Precogs ihn mit Leo Crow, einem vermeintlichen Kindermörder, konfrontieren. In Crows Wohnung findet er Bilder seines toten Sohnes. Der Drang, Crow zu töten, ist überwältigend. Doch Agatha flüstert: „Du hast die Wahl!“ Anderton widersteht. Crow, ein Strafgefangener, gesteht, erpresst worden zu sein, um Anderton zum Mord zu provozieren. Er greift zur Waffe und tötet sich selbst. Später entdeckt Andertons Kollege Witwer, dass die Precogs zwei ähnliche Morde sahen, ein „Echo“, das das System nicht erkannte. Precrime scheitert, weil es die Komplexität menschlicher Entscheidungen unterschätzt. Menschen sind keine Algorithmen. Sie können sich ändern, widerstehen, entscheiden.

Der nächste Schritt: Globale Kontrolle?

Das britische Experiment ist kein isolierter Fall. Wie lange, bis die EU eine „präventive Schutzverordnung“ einführt? Bis Versicherungen Prämien an „Verhaltenswahrscheinlichkeiten“ koppeln? Bis digitale Patientenakten ein „Verdachts-Rating“ enthalten? Die Technologie ist da, die Versuchung groß. Wenn Kontrolle möglich ist, wird sie genutzt. Immer. Das alte Menschenbild, eigenverantwortlich, frei, weicht einer neuen Macht-Paranoia: Der „digitalen Prävention“. Bürger werden zu Risiko-Avataren, deren Leben Algorithmen bestimmen. Großbritannien mag als Forschungslabor beginnen, aber die Idee verbreitet sich. Wer stoppt diesen Trend? Wer stellt sicher, dass Freiheit nicht Effizienz geopfert wird? Die Antwort liegt nicht bei Technokraten oder Ministern. Sie liegt bei Bürgern, die ihre Rechte einfordern. Denn wenn ein Algorithmus entscheidet, wer gefährlich ist, sind wir alle Verdächtige.